Story Flicks

Story Flicks簡介

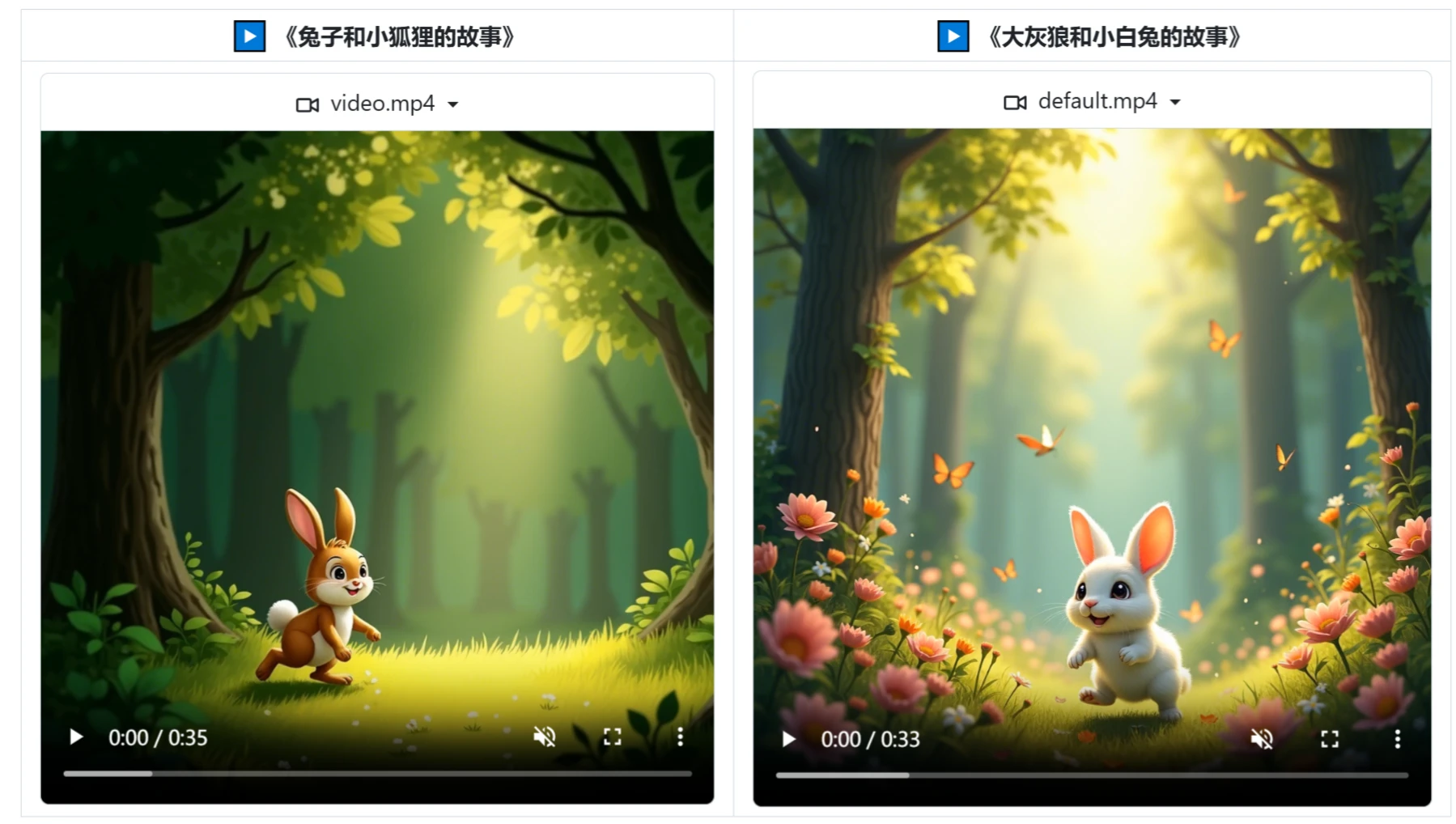

Story Flicks是一款開源的基于ai大模型打造的故事短視頻生成工具。它把先進的語言模型和圖像生成技術融合起來,依據用戶輸入的故事主題,能夠迅速生成包含AI生成圖像、故事內容以及音頻的視頻。它主要提供一鍵生成高清短視頻的服務,很適合那些想要快速制作視覺內容的創作者、教育者以及市場推廣人員。

功能特征:

智能生成:用戶僅輸入故事主題或者關鍵字,系統就能自動生成對應的短視頻,并且短時間內能給出多種創意成果。

多語言支持:Story Flicks能夠支持多種語言,用戶能按照自身需求挑選合適的語言來生成內容,這提升了使用時的便利性與靈活性。

圖像與音頻結合:Story Flicks除了能生成文本內容和故事情節,還能給視頻添加由AI生成的圖像以及背景音效,整體上增強了視頻的觀賞性。

多模態生成:Story Flicks通過大語言模型(LLM)進行智能解析,能夠綜合構建敘事框架,同步融合視覺、聽覺和文本元素。也就是說它不但能生成文本故事,還能自動創造出與故事相匹配的AI圖像、動態語音旁白和智能字幕。

AI圖像生成:Story Flicks運用圖像生成技術,給故事里的場景和角色營造出生動的視覺效果,讓生成的視頻內容在視覺上有很強的吸引力。

一體化音頻制作:其中包含動態語音旁白,這就意味著用戶不需要額外去錄制或者尋找音頻素材,系統會自動根據故事內容生成語音。

智能字幕:能夠自動編排字幕,這既便于聽障用戶理解視頻內容,也提高了視頻的可訪問性。

技術棧:后端運用Python和FastAPI,前端采用React、Ant Design和Vite,以此確保系統高效穩定運行,為用戶提供良好的開發體驗。

應用場景:

創意內容制作:適合短視頻博主、自媒體網絡紅人還有營銷人員,通過快速制作豐富的視覺故事來提升效率。

教育與培訓:在教育行業中大有用處,能夠為學員提供直觀的學習素材,例如教育性的短視頻內容。

娛樂與廣告:娛樂行業的從業者以及廣告制作人員可以借助它迅速創作宣傳視頻。

個人用途:普通個人用戶也能夠輕松制作紀念視頻、進行故事分享等。

Story Flicks的使用方法:

1. 下載本項目:

git clone https://github.com/alecm20/story-flicks.git

2. 設置模型信息

# 先切換到項目的 backend 目錄下 cd backend cp .env.example .env text_provider="openai" # 文本生成模型的提供商,目前支持 openai和 aliyun、deepseek、ollama、siliconflow,阿里云文檔:https://www.aliyun.com/product/bailian image_provider="aliyun" # 圖片生成模型的提供商,目前支持 openai和 aliyun、siliconflow openai_base_url="https://api.openai.com/v1" # openai 的 baseUrl aliyun_base_url="https://dashscope.aliyuncs.com/compatible-mode/v1" # 阿里云的 baseUrl deepseek_base_url="https://api.deepseek.com/v1" # deepseek 的 baseUrl ollama_base_url="http://localhost:11434/v1" # ollama 的 baseUrl siliconflow_base_url="https://api.siliconflow.cn/v1" # siliconflow 的 baseUrl openai_api_key= # openai 的 api key,可以只填一個 aliyun_api_key= # 阿里云百煉的 api key,可以只填一個 deepseek_api_key= # deepseek 的 api key,目前該 api_key 只支持文本生成 ollama_api_key= # 如果需要使用的話,請填寫ollama,目前該 api_key 只支持文本生成,并且不能用參數量太小的模型,推薦qwen2.5:14b 或者更大的模型。 siliconflow_api_key= # siliconflow 的文本模型目前只支持兼容 OpenAI 格式的大模型,如:Qwen/Qwen2.5-7B-Instruct。圖像模型只測試了:black-forest-labs/FLUX.1-dev text_llm_model=gpt-4o # 如果 text_provider 設置為 openai,這里只能填 OpenAI 的模型,如:gpt-4o。如果設置了 aliyun,可以填阿里云的大模型,如:qwen-plus 或者 qwen-max。ollama 的模型不能使用體積太小的模型,否則無法輸出正確的 json,可以使用如:qwen2.5:14b 或更大的模型。 image_llm_model=flux-dev # 如果 image_provider 設置為 openai,這里只能填 OpenAI 的模型,如:dall-e-3。如果設置了 aliyun,可以填阿里云的大模型,阿里云推薦使用:flux-dev,目前可以免費試用,具體參考:https://help.aliyun.com/zh/model-studio/getting-started/models#a1a9f05a675m4。

3. 通過docker啟動項目

在項目根目錄下,執行:

docker-compose up --build

4. 開始使用

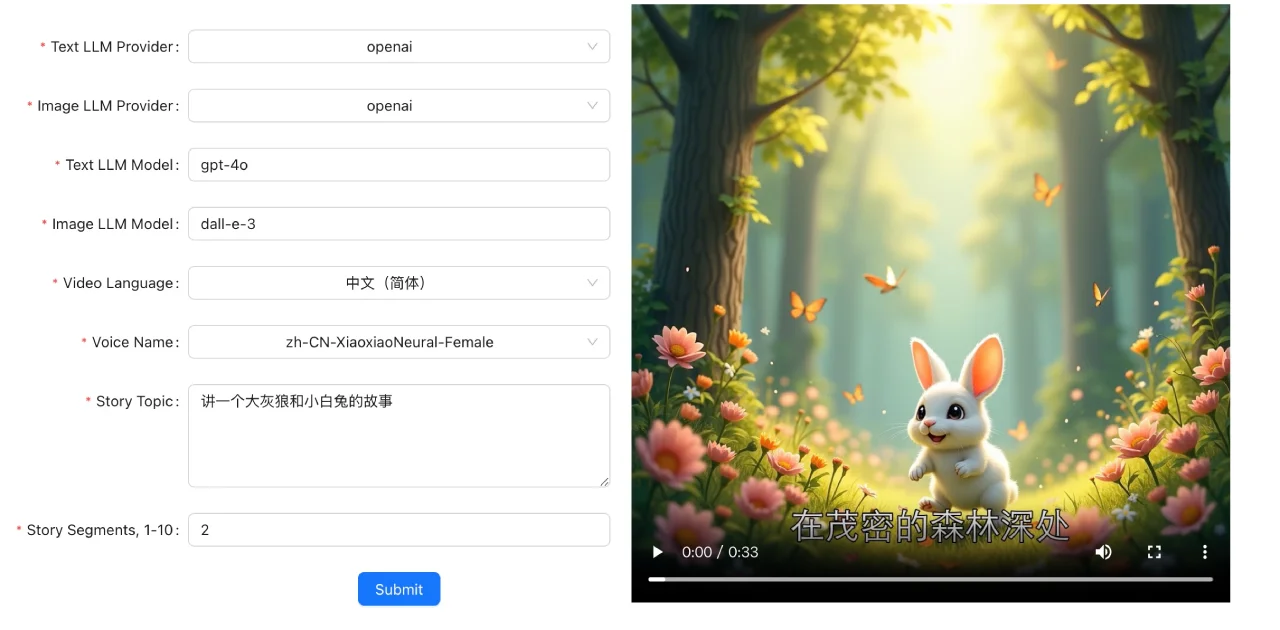

輸入故事主題:在生成工具的界面,選擇文本生成模型提供商、圖片生成模型提供商、文本模型、圖片生成模型、視頻使用的語言、聲音、故事主題以及故事段落。

視頻生成:點擊生成按鈕后,系統會基于AI技術展開處理,幾秒鐘內就能夠生成最終的視頻。

相關資訊:

提交您的產品

提交您的產品  Ai應用

Ai應用 Ai資訊

Ai資訊 AI生圖

AI生圖 AI生視頻

AI生視頻 FastbuildAI

FastbuildAI