JoyGen

JoyGen簡介

JoyGen 是由京東科技與香港大學合作開發的音頻驅動3D說話人臉視頻生成框架,一種新穎的兩階段框架,這個技術在于通過音頻輸入來驅動3D深度感知模型,提供精確的唇部與音頻同步,以精確模擬說話者的唇部動作和面部表情,讓生成的視頻更逼真,主要應用于視頻編輯和虛擬交互領域。

JoyGen使用了一個包含130小時高質量視頻的中文說話人臉數據集進行訓練。這個數據集與開放的HDTF(高分辨率深度圖數據集)結合,支持中文和英文輸入。

另外,JoyGen也考慮了音頻的情緒特征,能夠在生成的動畫中自然地表現出人物的情感變化,例如微笑或皺眉等,非常的強。

JoyGen核心功能:

多語言支持:JoyGen能夠處理中文和英文等多種語言的音頻輸入。

高質量視覺效果:通過細致的面部表情和唇部細節處理,生成的視頻極其逼真。

精確唇部同步:通過音頻特征分析和面部深度圖技術,使視頻中人物的唇部動作與音頻內容完美匹配。

視頻編輯優化:不僅生成新視頻,還能對現有視頻進行唇部運動的編輯,不需要從頭開始又制作整個視頻序列。

高效技術架構:采用單步UNet架構,可以讓視頻編輯流程更簡單了。

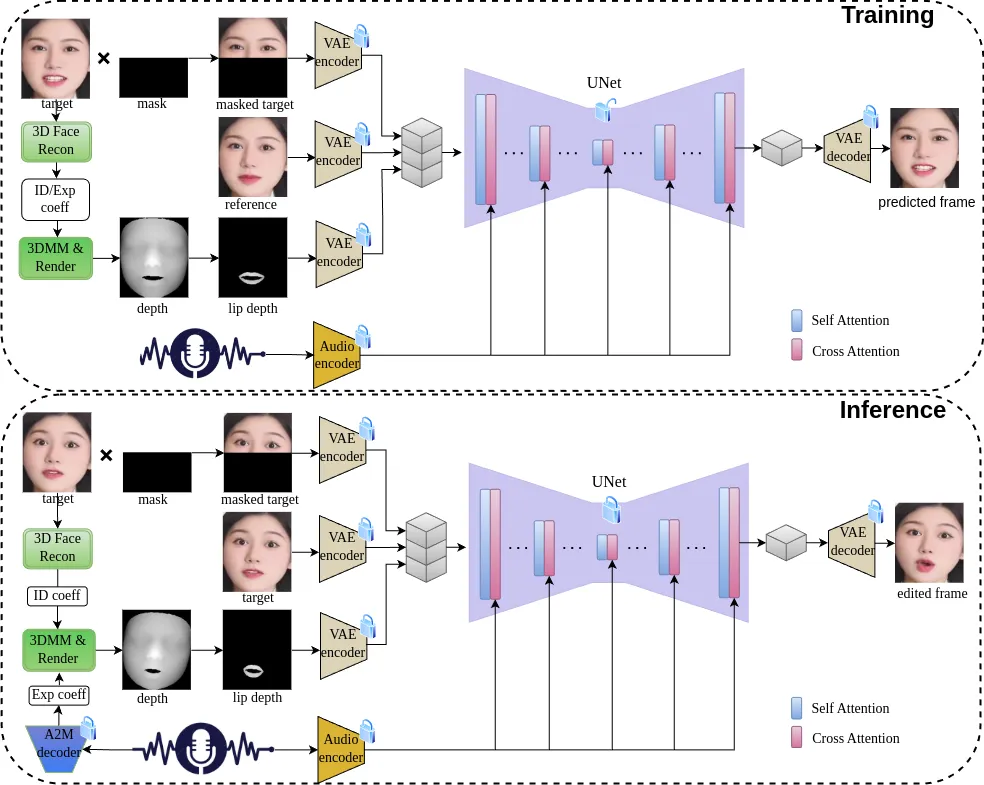

技術原理:

1. 音頻驅動的唇部動作生成:

利用3D重建模型從面部圖像提取身份特征,定義人物的獨特面部結構。

通過音頻到運動模型,將音頻信號轉換為控制唇部運動的表情系數。

結合身份和表情系數,使用可微渲染技術生成面部深度圖,為后續視頻合成準備。

2. 視覺外觀合成:

采用單步UNet網絡整合音頻特征與深度圖,直接生成包含精確唇部運動的視頻幀。

引入跨注意力機制,確保唇部運動與音頻信號高度一致,增強同步性。

通過優化過程(如L1損失函數)確保視頻質量,兼顧像素級和潛在空間的準確性。

如何使用JoyGen:

環境搭建:用戶需創建一個特定的conda環境,并安裝必要的依賴包,包括Nvdiffrast等特定庫。

預訓練模型下載:獲取JoyGen的預訓練模型,包括3D模型、音頻到運動模型等,這些資源通常在項目GitHub頁面上提供。

運行推理:通過執行特定的腳本和參數,用戶可以將音頻文件轉換為帶有逼真唇部同步的3D說話人臉視頻。

JoyGen應用:

JoyGen將復雜的人臉視頻生成大大簡化了,它在數字人內容創作、虛擬會議、娛樂等地方有非常大的作用。

GitHub:https://github.com/JOY-MM/JoyGen

提交您的產品

提交您的產品  Ai應用

Ai應用 Ai資訊

Ai資訊 AI生圖

AI生圖 AI生視頻

AI生視頻 開源AI應用平臺

開源AI應用平臺