Tarsier

Tarsier簡介

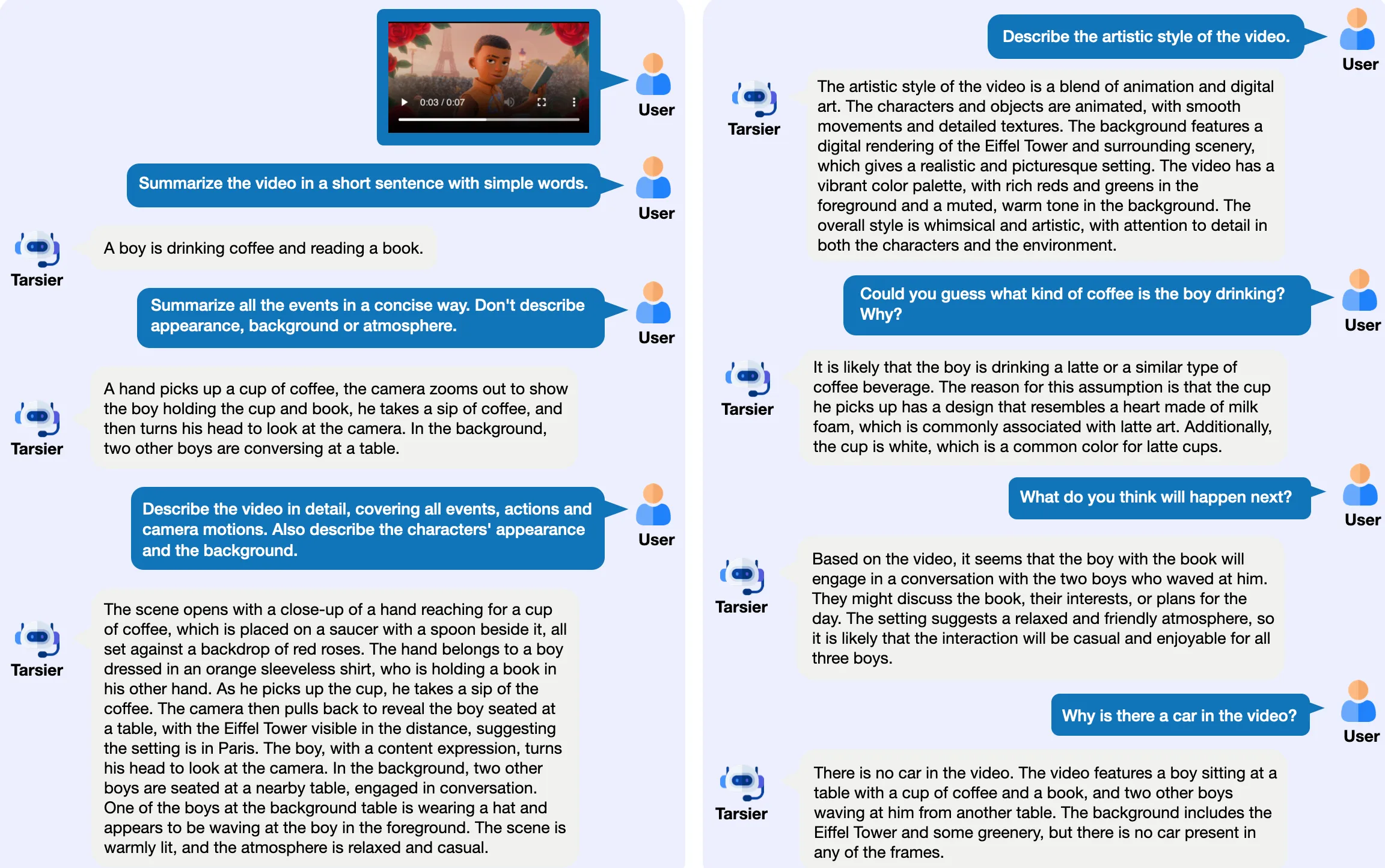

Tarsier是字節跳動推出的一系列大規模視覺語言模型(LVLM),專注于視頻理解任務,包括視頻描述、問答、定位和幻覺測試等功能。

Tarsier主要功能

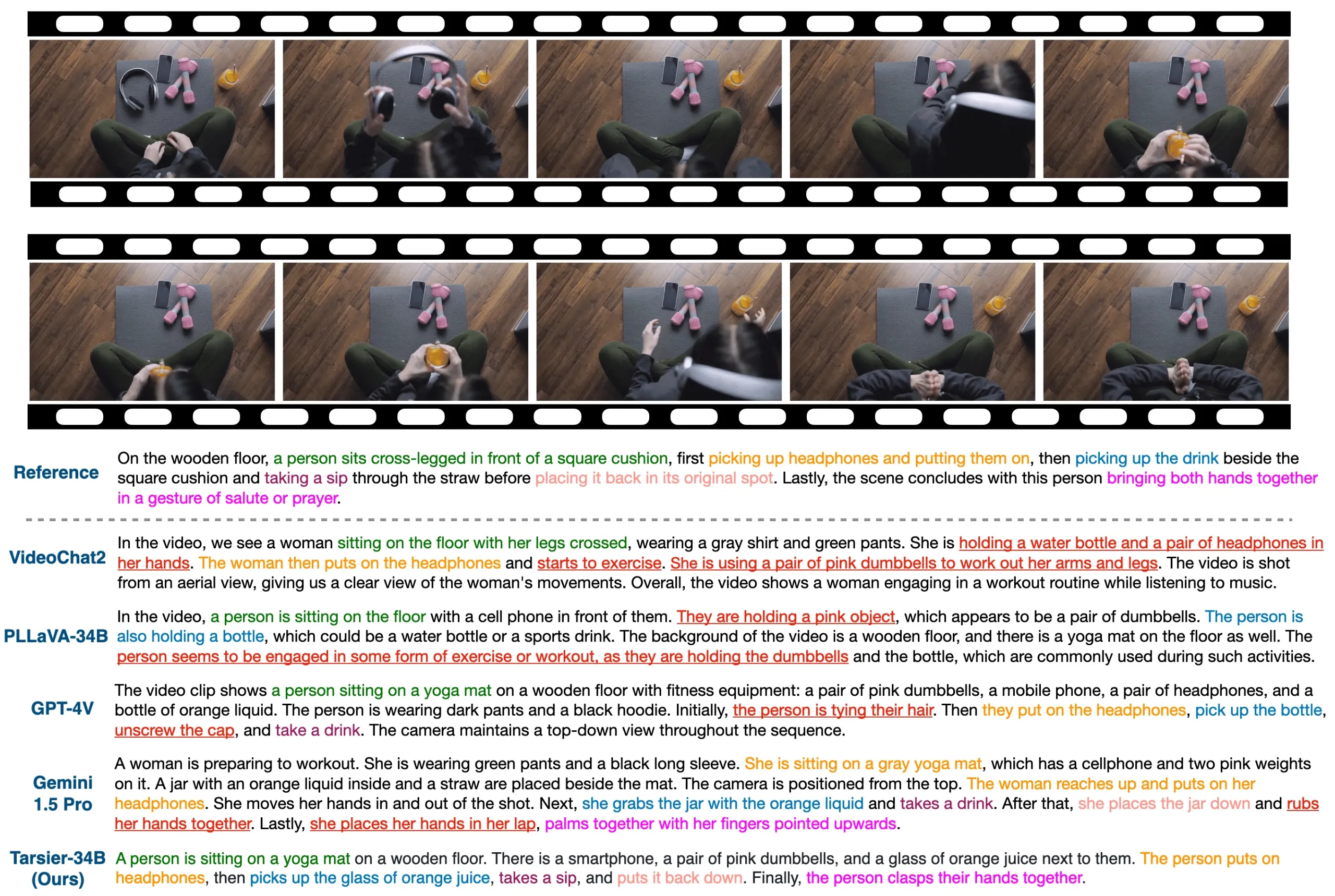

視頻描述生成:Tarsier能生成高質量的視頻描述,覆蓋視頻中的各種細節,包括動作、場景和情節,幫助用戶更好地理解視頻內容。

問答能力:Tarsier模型支持視頻問答功能,用戶可以基于視頻內容提出問題,模型將提供相關的答案。

定位功能:檢測并定位視頻中特定事件發生的時間,支持多視頻段的定位,可以在視頻中識別和標記特定對象或場景。

幻覺測試:通過優化訓練策略,Tarsier2顯著減少了模型生成虛假信息的可能性。

多語言支持:支持多種語言的視頻描述生成。

Tarsier應用場景:

內容創作:Tarsier可以幫助內容創作者生成視頻描述,提升視頻的可訪問性和搜索引擎優化(SEO)效果。

教育領域:在教育視頻中,Tarsier可以提供詳細的內容描述,幫助學生更好地理解學習材料。

社交媒體:社交平臺可以利用Tarsier生成視頻內容的自動描述,增強用戶體驗。

視頻監控:在安全監控領域,Tarsier可以分析視頻流并生成實時描述,幫助安全人員快速識別潛在威脅。

機器人:為指定任務生成詳細的步驟指令。

智能駕駛:幫助車輛識別道路情況,并輔助進行決策。

Tarsier模型的最新版本Tarsier2在多個方面進行了顯著的改進,特別是在數據量和多樣性方面。預訓練數據從1100萬擴展到4000萬視頻文本對,增強了模型的學習能力。此外,Tarsier2在監督微調階段引入了細粒度時間對齊,進一步提高了視頻描述的準確性和細節捕捉能力。通過直接偏好優化(DPO)訓練,Tarsier2能夠生成更符合人類偏好的視頻描述,減少生成幻覺的可能性。

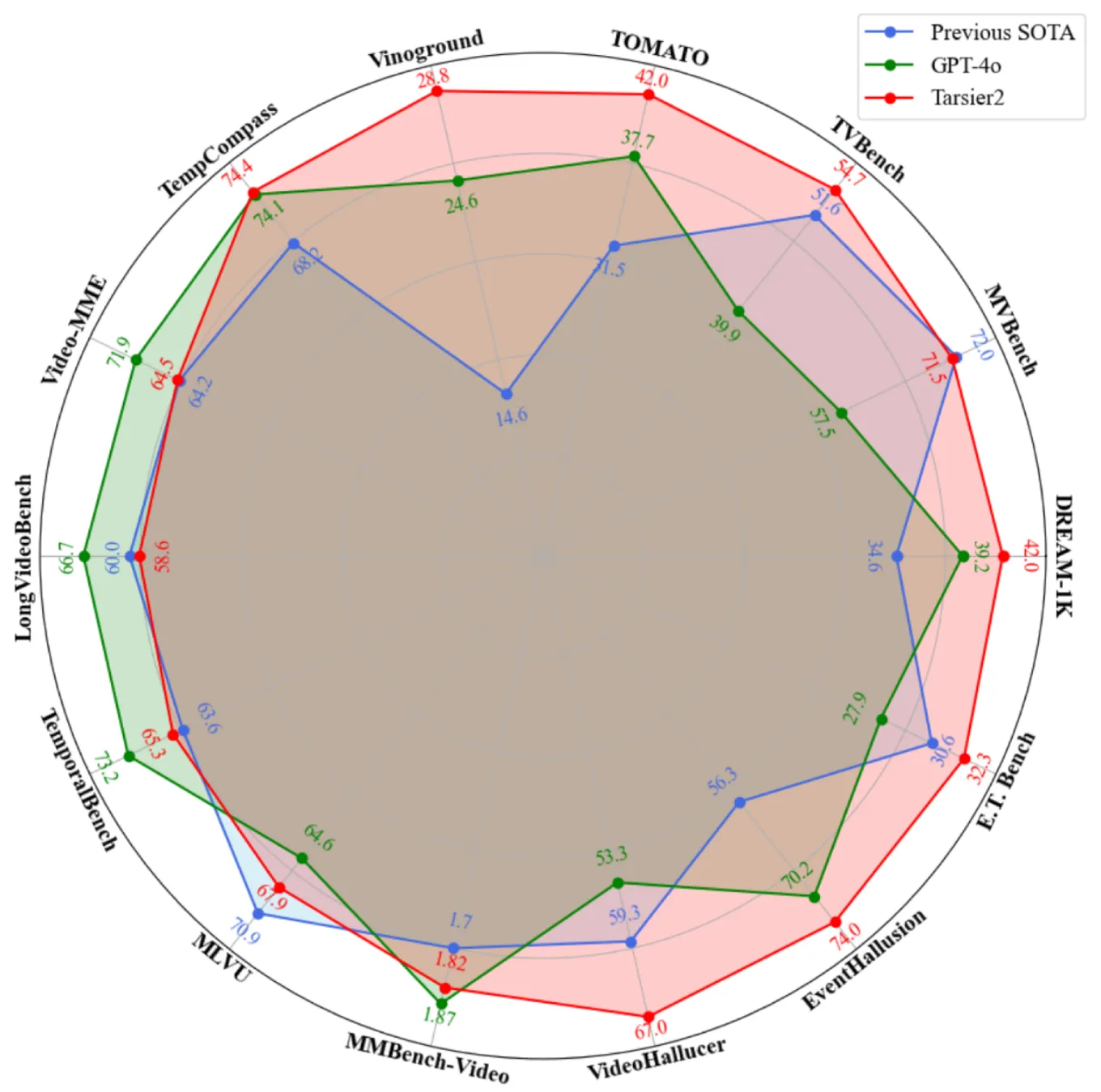

在性能評估方面,Tarsier2在DREAM-1K基準測試中表現出色,其F1分數比GPT-4o高出2.8%,比Gemini-1.5-Pro高出5.8%。在15個公共基準測試中,Tarsier2取得了新的最佳結果,涵蓋視頻問答、視頻定位、幻覺測試和問答等功能,展示了其作為強大通用視覺語言模型的多功能性。

除了視頻描述之外,它還在問答、grounding和embodied intelligence等任務中展現出強大的性能。

論文:https://arxiv.org/abs/2501.07888

Code: https://github.com/bytedance/tarsier

Dataset: https://huggingface.co/datasets/omni-research/DREAM-1K

Demo: https://huggingface.co/spaces/omni-research/Tarsier2-7b

與Tarsier相關工具

- 用戶登錄

提交您的產品

提交您的產品  Ai應用

Ai應用 Ai資訊

Ai資訊 AI生圖

AI生圖 AI生視頻

AI生視頻 FastbuildAI

FastbuildAI